新闻人物

宋睿华:我们赖以生存的意义

日期:2021-05-13访问量:我们很多人都没有意识到,自己有一个非常不起眼但也是很了不起的能力,那就是:我们的大脑每时每刻都在制造意义。事实上,我们每一天都沉浸在语言的海洋里,每天我们要听到上百句话,我们要说出成千个字,甚至会读到上万个词,而我们的大脑在毫无知觉的情况下就能把这些语言转化成意义。可以说,这个过程是持续的,自主的,同时又是不知疲倦的。

那么,语言到底是怎么经过大脑的处理变成意义的?这个问题很难回答,语言学家和认知学家们也没有搞得很清楚。但是我们可以尝试着去了解这个过程,这也是《我们赖以生存的意义》(Louder Than Words)所要解开的难题。

1.我们如何制造意义,决定了我们何以为人

让我们先从一个问题开始,假如我告诉你:“今天我是骑自行车来的,你会怎么理解它?”

可能你会告诉我,这个句子里的词你都认识,你可能会这样说:“今天”表示时间;“我”是一个主语;“是”是一个谓语动词,“骑自行车”是一种来的方式,那么你可能会告诉我:这不就是表达“某一个时间,某个人用某种方式做了某件事”吗?但是等一等,虽然你解释了这句话的含义,但是这真的是你的大脑千分之一秒反应出来的意义吗?因为,即便是一个没有上过学的、五六岁的孩子,他虽然不知道什么是主语以及什么是谓语,但是只要他见过骑自行车的人,也一样可以理解这句话。

那么,我们大脑中到底发生了什么?《我们赖以生存的意义》这本书,就为你解开了答案:作者本杰明·伯根(Benjamin K. Bergen)在探讨大脑如何成为一个意义制造机,同时,他也在探讨人何以为人。

没有其他动物可以像人类一样使用语言。当然了,你可以说,人有人言,兽有兽语,一种斑胸草雀的鸟唱起歌来,速度和复杂度都与人类相当。座头鲸的歌声可以轻松持续几个小时,人类用新的方式组词造句,看似独特,可是蜜蜂也有类似的做法,用跳舞来传递消息。

人类的语言的独特之处在于,我们几乎可以用语言传达我们想要表达的任何意义。我们可以谈论存在的事物,也可以谈论不存在的,比如植物和僵尸,这是我的儿子每晚必听的故事和最爱的游戏。

关于“何以为人”,曾经主流的观点认为人是一个理性的思考机器,语言是思想符号。这一观点影响了语言学、认知科学以及人工智能的发展,思想语言盛行的30年刚好和人工智能领域的符号主义相对应,人们用符号、构词和语法树去剖析意义。

当然总有一些解释不通的问题。从20世纪90年代开始,一些认知科学研究者不约而同地提出了不同的观点:我们对语言的理解,就是在我们的脑海进行模拟,看看这些句子描述的事物,若换做我们自己亲身去体验,会是怎样的。这就是体验革命。有趣的是,几乎同时,人工智能领域里的神经网络迅速发展,今天我们知道深度神经网络带来了人工智能的跳跃式发展,我们称之为神经主义盛行的30年正好与体验革命同时发生。

2.具身模拟,意义来源于肉身与大脑的“跨界”合作

心智的奇特之处在于,它喜欢跳跃与留白,会自动补上情节里的“洞”。那些引人入胜的电影,从来都不需要完整镜头的呈现,我们照样可以毫无困难地看懂。或许,这就是所谓的“脑补”。那么脑补的来源是什么呢?

20世纪90年代开始,一些认知科学家不约而同地想到了“具身模拟”(Embodied Simulation)这种可能性:我们思考以及使用语言的能力,其实不光是大脑中负责管理语言的区域在起作用,还与我们的肉身相关,大脑与肉身的通力合作才有了意义的脑补。

这里的肉身指的是:在我们日常生活中,我们会用视觉看,用听觉听,用嗅觉闻,还会用味觉尝,以及我们会有触感,还有一些运动神经等各种各样的模态。所以,每个孩子出生以后,他所接触到这个世界所有感觉,都是各种各样的模态在共同发挥作用。而在父母们对孩子讲话、孩子慢慢学会说话的过程中,语言和这些多模态的体验是密不可分的。

科学的价值在于可观察、可重复的观察,从而对预言进行证实或证伪。可是了解大脑如何运作太难进行观察,没有办法探入,没有办法称量。好在,一小队勇于开拓的科学家着手研发实验工具,要用实验来研究具身模拟假说。在《我们赖以生存的意义》一书中,就展现了很多精妙的实验。

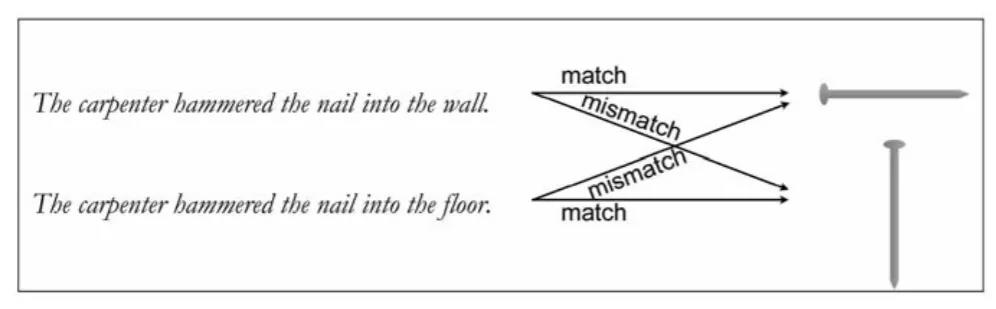

其中有一个这样的实验让我印象深刻,认知心理学家罗尔夫·扎瓦恩(Rolf Zwaan)做了一系列实验,来探究语言在头脑里唤起的只是提到的物体的视觉形象,还是模拟了一些细节,比如方向?扎瓦恩让被试坐在屏幕前,然后屏幕上会打出一个句子,比如:一位木匠把钉子敲到了墙里。接着,他会看到一张图片,这张图片可能是一个钉子,也可能是一头大象,然后教授问被试看到的图片是不是之前句子里提及的物品。这里面有个实验控制的环节,就是教授放出的钉子图片其实并不一定是同一张图片——钉子有可能是横着的,也有可能是竖着的。为什么这样做?因为实验人员很巧妙地加了另外一个句子,那就是:木匠把钉子敲到了地板里。

然后罗尔夫·扎瓦恩的研究团队发现:人们在做判断的时候,时间上有了明显的差异。如果图片里的钉子是敲到墙里的,而且图片展示的是水平的钉子的话,人们判断的速度会更快。如果这个钉子是敲到地板上,而且图片展示的是垂直的钉子的话,人们的判断速度也会加快。所以这个实验就刚好验证了大家的猜测:人们在理解一个句子的时候,可能在脑海中模拟了它的场景,包括存在的方向性指引。

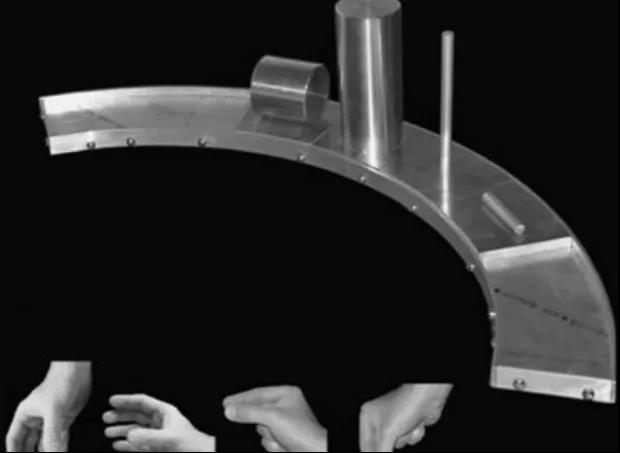

还有另外一个例子。比如思考类似“年轻的科学家看着玻璃杯”这样一个句子,如果只是单纯看看而已,你根本没有必要用到自己的手。于是问题就变成,理解类似这样一个句子,会不会引发运动系统去模拟我们的手抓住一个玻璃杯?为了找到答案,维多利亚大学的研究者发明了一个尺寸大得有点儿离谱且难以移动的奇妙装置,从外形上看像是来自旧石器时代早期,而他们也恰如其分地参考恐龙(dinosaur)的命名方式将这个奇妙装置命名为“Graspasaurus”(音译为格拉斯帕龙)。

研究者请被试先听一些句子,描述的是人们在看一些物体,比如“玻璃杯”和“订书机”,然后提示被试去抓格拉斯帕龙装置上的其中一个物体,看被试要用多长时间才能做到。结果再次表明:当人们在听到的语言里面提到一个物品的时候,会激活自己的运动神经。如果被试要用到的手形与抓住句子里描述的物体要用到的手形(如握住)是兼容的,那么被试的反应就会更快,哪怕实验中的句子根本就没有提到要抓住那些物体。比如“玻璃杯”,就会激活平时人们是怎么握玻璃杯的部分运动神经。

3.多模态将是AI开启常识之门的钥匙

我是做人工智能的科学研究者,那么我自然会想,AI是不是也可以拥有这种“制造意义”的心智呢?尤其是当我从信息检索的领域转到了自然语言处理领域的时候,我就在思索:到底什么是自然语言理解?AI的理解难道仅仅是可以完成一个任务?我觉得并不是这样。

很多的时候我们虽然听懂了,但不一定要去做出动作,那么我们是如何度量自己确实听懂了呢?受这本书的启发,我觉得可以找到一个方法去检测自然语言的理解程度,那就是:AI能不能把一个句子理解成对应的画面,就像我们在脑海里做的那样。如果可以给 AI造就一个“具身模拟库”,那么它们是不是也可以在实际体验中利用以往的经验去模拟新的情况。

非常感谢电影工作者,给我们提供了一个非常好的“具身模拟库”,把我们的头脑没法展示出来的东西,通过电影画面真实地再现了出来——演员的表演把人物的动作、神情以及其他各方各面都表现得淋漓尽致。比如说我们在拍电影的时候,我们通常不会把一个情景从头拍到尾,想要描述吃饭的情景,我们可能是通过几个零散的镜头,就已经理解了这家人在吃饭,有时候我们是留白,故意不去把所有的镜头都展示出来,文字也是一样,这也就是我们上面说的脑补。

那么,我们也希望能够让AI像人一样用常识补上这些“空白”。但是仅仅通过文字是很难做到的,那么我这里有一个大胆的预言,就是:对多模态的研究可能会带来自然语言理解的重大突破, 多模态将是AI开启常识之门的钥匙。

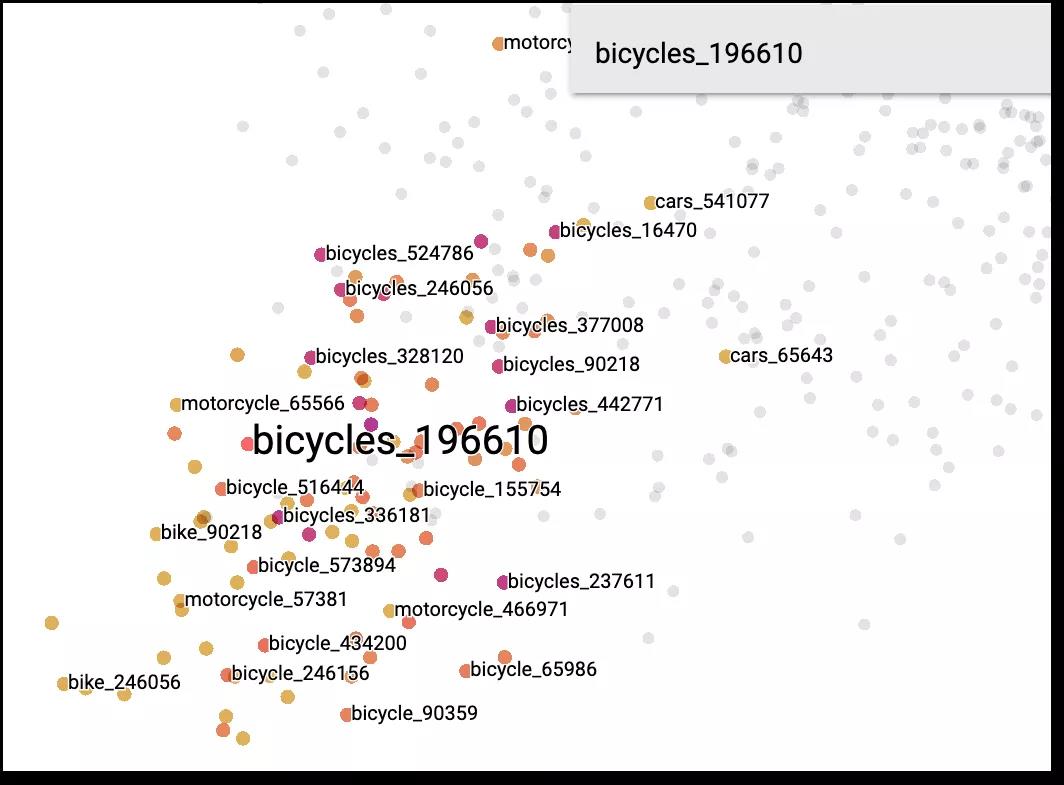

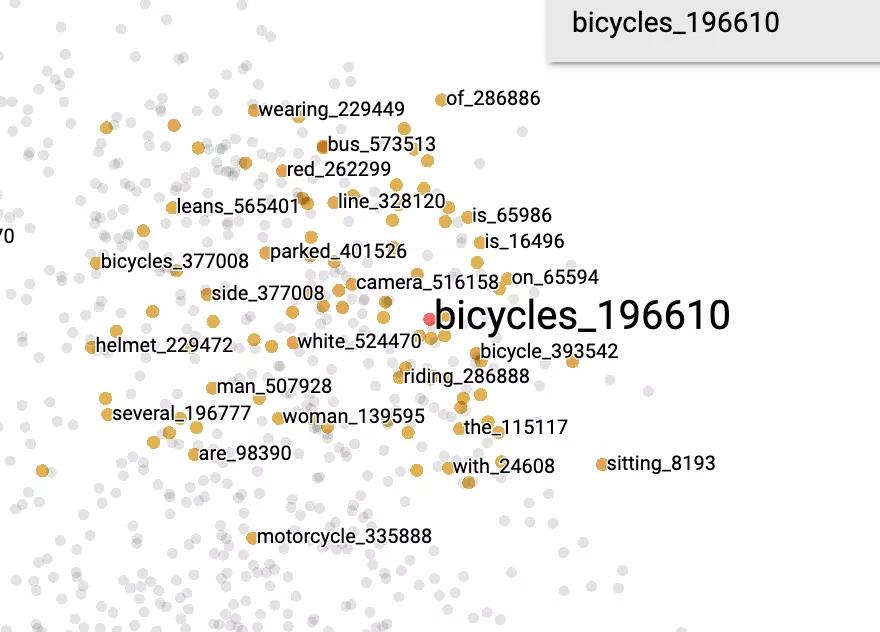

这里我想给大家看两张图,这是中国人民大学和中科院计算所一起正在进展的一个项目。我们的目标是做一个大规模的图文多模态预训练模型,并回答多模态模型到底比单模态(仅仅用图像或者仅仅用文本训练得到的)模型多了什么?下面展示的两张图:一张是用BERT文本预训练模型得到的结果,而另一张则是用UNITER多模态预训练模型得到的结果。

我们就回到之前的例子,“自行车”到底在文本的数据上学到的相似的词有哪些?我们发现它周围有很多的不同句子里出现的自行车,或者是摩托车,或者是汽车。

而我们看多模态这张图,我们会发现如果利用了图片,我们可以知道自行车周围有一些比如说“骑”这样的词,比如说“男人、女人”,因为他们是骑车的人,还有“头盔”,“停车”,甚至有“on”这样的表示“位于车上”的词。

BERT:文本单模态数据预训练模型

UNITER:图文多模态数据预训练模型

我甚至发现了“摄像头”这个词,我当时很不理解为什么会有它出现?后来,我们从数据库里调出一个图片,才发现原来是很多人会在车的侧面加装一个摄像头,这样就可以拍下来骑车过程中的图景了。

所以,我说《我们赖以生存的意义》对我们研究人工智能的工作有非常大的启发,我也希望我的AI有一天也拥有这样的能力。最后,我要送给大家一句话,那就是:没有灵光乍现,有的只是终于看见。

检测到您当前使用浏览器版本过于老旧,会导致无法正常浏览网站;请您使用电脑里的其他浏览器如:360、QQ、搜狗浏览器的速模式浏览,或者使用谷歌、火狐等浏览器。

下载Firefox

下载Firefox