学院新闻

我院师生论文被国际顶级期刊TPAMI录用

日期:2021-12-13访问量:12月10日,中国人民大学高瓴人工智能学院师生论文被国际顶级期刊《IEEE模式分析与机器智能汇刊》(IEEE Transactions on Pattern Analysis and Machine Intelligence,简称TPAMI)录用。TPAMI是计算机视觉和人工智能领域公认的顶级国际期刊,是中国计算机学会(CCF)推荐的A类期刊,也是中国人民大学核心期刊目录中的A+类期刊,影响因子16.389。

2021年1月至今,高瓴人工智能学院已发表或被录用CCF A类期刊和会议论文76篇、CCF B类期刊和论文31篇。

论文介绍

论文题目:Class-aware Sounding Objects Localization via Audiovisual Correspondence

作者:胡迪,卫雅珂,钱锐,林巍峣,宋睿华,文继荣

通讯作者:胡迪

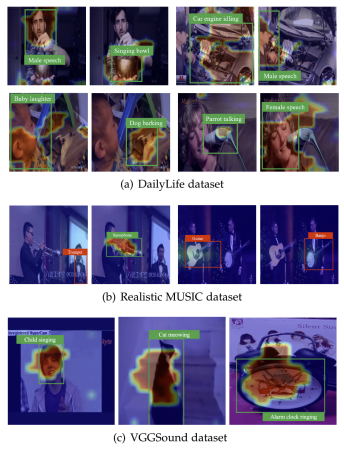

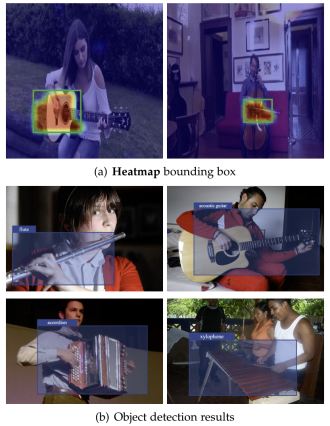

论文概述:视听场景在我们的日常生活中无处不在。对人类来说,定位不同的发声物体轻而易举,但对机器来说,在没有类别注释的情况下实现对发声物体的判别性定位,即不仅定位出发声物体而且辨别出发声物体的类别,相当具有挑战性。为了解决这个问题,我们提出了一个两阶段的学习框架,充分利用音频和视觉之间的对应关系来定位和识别发声物体。首先,我们在单声源场景中通过粗粒度的视听一致性来确定发声区域。然后,根据发声区域提取视觉特征建立物体的视觉表征字典。进而,在复杂的多声源场景中,我们通过参考该字典确定画面中存在的物体,并进一步利用更细粒度的类别级别的视听一致性作为监督,将音频分布和发声物体的视觉分布进行对齐。在真实数据集和合成数据集的实验表明,我们的模型在定位并识别发声物体及过滤不发声物体方面具有优势,图1给出了在不同数据集上判别性声源定位结果示例。此外,经判别性声源定位任务训练所得的物体定位和识别结果能够进一步为物体检测器提供高质量的“伪”监督训练对,从而实现无监督物体检测,图2给出了可视化示例。

图1 判别性声源定位结果示例

图2 无监督物体检测结果示例

检测到您当前使用浏览器版本过于老旧,会导致无法正常浏览网站;请您使用电脑里的其他浏览器如:360、QQ、搜狗浏览器的速模式浏览,或者使用谷歌、火狐等浏览器。

下载Firefox

下载Firefox