学院新闻

我院师生论文被CCF A类会议CVPR 2023录用

日期:2023-03-08访问量:2月27日,中国计算机学会(CCF)推荐的A类国际学术会议CVPR 2023论文接收结果公布。中国人民大学高瓴人工智能学院师生有6篇论文被录用。国际计算机视觉与模式识别会议(Conference on Computer Vision and Pattern Recognition,简称CVPR)是由IEEE举办的计算机视觉和模式识别领域的顶级会议,在世界范围内每年召开一次,本届会议录用率为25.78%。

论文介绍

论文题目:HOTNAS:Hierarchical Optimal Transport for Neural Architecture Search

作者:杨杰超,刘勇,许洪腾

通讯作者:刘勇

论文概述:现有神经网络搜索方法(Neural Architecture Search, NAS)方法逐渐从搜索整个网络过渡到搜索相对较小的单元子网络来减少搜索成本,其中主要面临的挑战是同时测量不同网络中单元子网络的微观结构相似度和整体宏观结构的差异。最近最优传输方法(optimal transport,OT)由于能够同时学习不同网络的操作和结构相似性成功应用于NAS中。然而现有基于最优传输的NAS方法忽略了网络中不同子网络的相似性或者局限于单一网络单元结构搜索。 为了解决这些问题,我们提出一种基于分层最优传输的方法称为HOTNN 测量网络的相似性。其中在单元子网络层面,同时考虑了单元中每个节点的相似性和单元内信息流动成本的差异;在宏观网络层面,同时考虑不同网络中单元子网络之间的相似性和网络中每个单元子网络在全局位置上的差异。为了证明HOTNN的有效性,本文进一步探讨了HOTNN距离在基于贝叶斯优化的NAS框架下的应用。实验结果表明我们所提出方法在多个任务中均表现出更好的性能。

论文介绍

论文题目:Fair Scratch Tickets: Finding Fair Sparse Networks without Weight Training

作者:唐鹏威*,姚巍*,李智聪,刘勇

通讯作者:刘勇

论文概述:最近的研究表明,计算机视觉模型存在着损害公平性的风险。大量的工作使用预处理、处理中和后处理这三类方法来缓解计算机视觉中的不公平性。本文从彩票假说的视角提出了一种新的公平性处理中学习范式。对于一个随机初始化的稠密神经网络,我们无需训练模型权重,而是仅仅通过找到合适的二进制掩码来获取公平的稀疏子网络。有趣的是,据我们所知,我们首次发现在随机初始化的稠密网络中,存在具有先天公平性的稀疏子网络,而且其准确性-公平性的权衡性能与现有的处理中方法训练的稠密神经网络相当。我们将这些公平的子网络称为公平初始彩票(FSTs)。我们还从理论上为它们提供了公平性和准确性的保证。在实验中,我们研究了FSTs在多种数据集、标签属性、随机初始化方法、稀疏模式和公平性代理函数上的存在性。我们还发现FSTs可以跨数据集迁移,并且还研究了FSTs的其他属性。

论文介绍

论文题目:Modeling Video as Stochastic Processes for Fine-Grained Video Representation Learning

作者:张恒,刘大庆,郑琪,苏冰

通讯作者:苏冰

论文概述:目前视频表征学习方法大多通过同一类视频的对齐或探索多个视角之间的相关性来学习细粒度的时空特征,却忽略了每个视频内的动态过程。在本文中,我们提出通过一种新的基于过程的对比学习方法来学习帧级别的细粒度视频表征,旨在区分细粒度的动作阶段并同时捕获动作中的动态变化。具体而言,我们将视频建模为有目标导向的随机过程,一种服从时变高斯分布的布朗桥过程,并通过基于该过程的对比损失,将视频表征映射到布朗桥的隐空间中,使正确的视频帧嵌入到目标布朗桥的相应位置。我们为不同的标注场景设计了专门的布朗桥构建策略,可以用于自监督或弱监督学习。在基准数据集上的多种视频理解任务实验,证明了方法的有效性和泛化性。

论文介绍

论文题目:Transfer Knowledge from Head to Tail: Uncertainty Calibration under Long-tailed Distribution

作者:陈嘉浩,苏冰

通讯作者:苏冰

论文概述:如何估计给定模型的不确定性是一个至关重要的问题。当前的校准技术平等对待不同的类别,因此隐含地假设训练数据的分布是平衡的,但忽略了现实世界的数据通常遵循长尾分布的事实。在本文中,我们探讨了校准从长尾分布训练的模型的问题。由于不平衡训练分布和平衡测试分布之间的差异,现有的温度缩放等校准方法不能很好地推广到这个问题。用于域适应的特定校准方法也不适用,因为它们依赖于不可用的未标记目标域实例。从长尾分布训练的模型往往对头类过于自信。为此,我们提出了一种新的基于知识转移的校准方法,通过估计尾类样本的重要性权重来实现长尾校准。我们的方法将每个类的分布建模为高斯分布,并将头类的源统计数据视为先验,以校准尾类的目标分布。我们自适应地从头部类转移知识以获得尾部类的目标概率密度。重要性权重由目标概率密度与源概率密度的比率来估计。在 CIFAR-10-LT、MNIST-LT、CIFAR-100-LT 和 ImageNet-LT 数据集上进行的大量实验证明了我们方法的有效性。

论文介绍

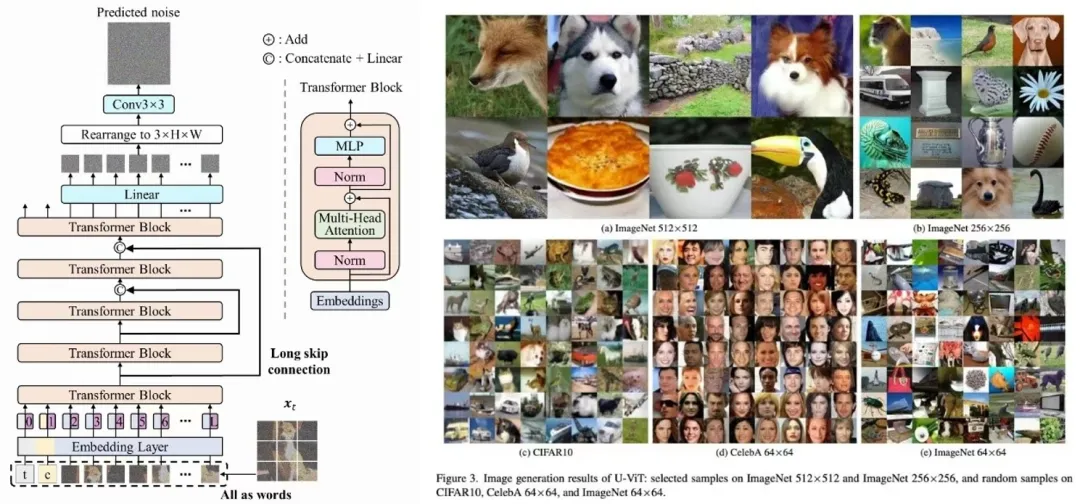

论文题目:All are Worth Words: A ViT Backbone for Diffusion Models

作者:鲍凡,聂燊,薛凯文,曹越,苏航,李崇轩,朱军

通讯作者:李崇轩,朱军

论文概述:我们为扩散概率模型设计了一个基于transformer的架构U-ViT。类似U-Net,U-ViT也引入了跨层链接,大大提升了图像建模性能。U-ViT无论是在像素空间或是在隐空间上都能取得和SoTA可比甚至更好的效果。代码已经放出:https://github.com/baofff/U-ViT,对于代码我们也做了不少优化,能够在两张a100上以1024的batch size高效训练我们最大的imagenet 512x512模型。

论文介绍

论文题目:Compacting Binary Neural Networks by Sparse Kernel Selection

作者:王一凯,黄文炳,董胤蓬,孙富春,姚安邦

论文概述: 二值神经网络(BNN)采用用1比特卷积权重来提高存储和计算的效率。本文的出发点是基于先前揭示的一个现象,即在训练完成后的BNN中,二值卷积核几乎是满足幂律分布的。这一现象鼓励我们压缩典型的BNNs,并学习选择非重复的二值卷积核来获得性能的提升。具体来说,我们将神经网络二值化过程视为从二值卷积核空间中选择一个较小的子集,我们提出“排列梯度直通估计”(PSTE)对选择过程进行端到端的优化,并保持所二值卷积核的非重复占用。通过图像识别和目标检测等实验的验证,我们的方法相比BNNs能够进一步减少模型大小和计算开销,且在与BNNs给定同样模型大小和计算开销时可以获得更高的识别效果。

检测到您当前使用浏览器版本过于老旧,会导致无法正常浏览网站;请您使用电脑里的其他浏览器如:360、QQ、搜狗浏览器的速模式浏览,或者使用谷歌、火狐等浏览器。

下载Firefox

下载Firefox