学术讲座

AI之夏研招讲座|王希廷:大模型解释与对齐

日期:2024-06-07访问量:

“AI之夏”研招系列学术讲座第17讲,由人大高瓴人工智能学院王希廷准聘助理教授为大家开讲啦!大模型时代,可解释和模型对齐变得至关重要。大模型对人的工作生活影响越来越大,但却更加难以理解和控制。OpenAI对外支持的七大研究方向中,可解释和模型对齐就是其中两个。我们应该怎么让深度学习模型变得更透明、可理解、更容易训练、调试和优化,确保它和人类意图对齐呢?这次报告将围绕这些问题进行探讨,介绍我们近期可解释人工智能(XAI)以及利用强化学习从人类反馈学习(RLHF)的方法,探索越狱等大模型安全问题、推理等性能提升的可能解决方案。

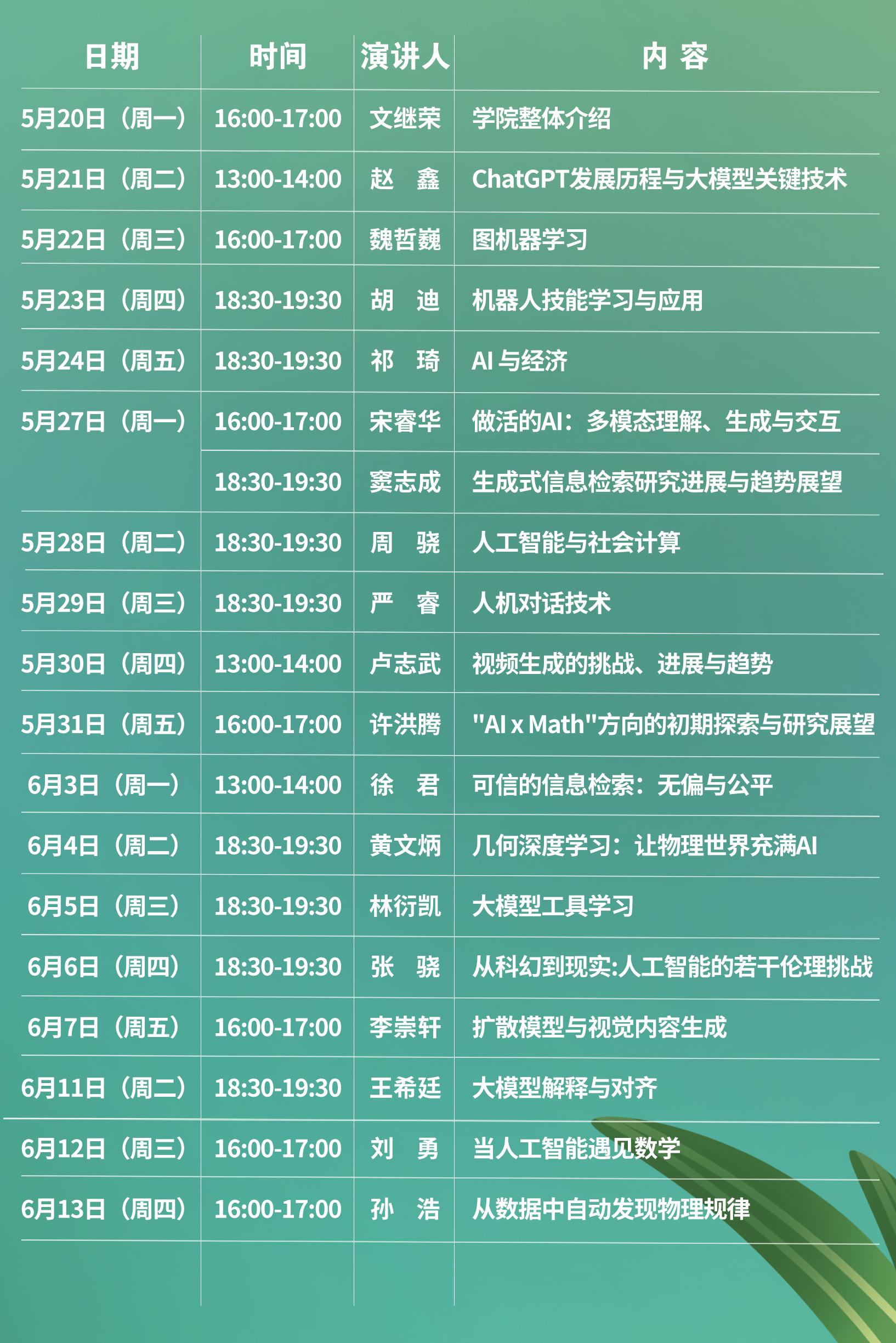

讲座时间:6月11日 18:30-19:30

腾讯会议:539-231-012

报告题目:大模型解释与对齐

主讲人:王希廷

讲者简介:王希廷曾任MSRA社会计算组首席研究员,本科、博士毕业于清华大学。研究兴趣为可解释、负责任的人工智能,相关科研成果落地全球占有量第二的必应搜索引擎。两篇论文被CCF-A类期刊TVCG评选为封面论文,被邀请担任IJCAI、AAAI领域主席,加入IEEE VIS组委会担任档案主席,Visual Informatics编委,被评为AAAI 2021 杰出高级程序委员。两次受邀在SIGIR可解释推荐研讨会上发表主旨演讲,是CCF和IEEE高级会员。

检测到您当前使用浏览器版本过于老旧,会导致无法正常浏览网站;请您使用电脑里的其他浏览器如:360、QQ、搜狗浏览器的速模式浏览,或者使用谷歌、火狐等浏览器。

下载Firefox

下载Firefox